模型上下文协议(MCP):AI应用与外部数据集成的新标准

Claude 在 2024 年末推出的**模型上下文协议(Model Context Protocol,简称 MCP)**迅速获得了开发者和社区的广泛关注与认可。作为一名曾在过去一年中参与过多个小型 AI 项目开发的开发者,我深刻体会到将 AI 模型集成到现有系统或第三方服务中的种种困难。

MCP 的出现恰逢其时,它不仅解决了这些痛点,还带来了一个开放、标准化的生态愿景。下面,我将从开发者视角出发,结合 MCP 的工作原理和优势,分析它为何能被广泛接受。

一、AI 集成开发的痛点:为什么需要 MCP?

在 AI 项目开发中,将模型与外部系统对接往往是一大挑战。以我个人的经验为例,无论是连接本地数据库还是调用第三方 API,整个过程都充满了复杂性和不确定性。市面上虽然有一些工具和框架试图解决这个问题,但效果却不尽如人意:

LangChain 和 LlamaIndex

这两个开源项目主打"几行代码实现 AI 功能"的理念,在展示 Demo 时确实方便。然而,一旦业务需求变得复杂,它们的短板就暴露无遗:- 代码抽象过高:高层次封装虽然降低了入门门槛,但在实际开发中,这种设计导致代码难以调试和扩展,编程体验极差。

- 生态混乱:项目过于追求商业化,忽视了社区生态的长期建设,文档和更新常常跟不上实际需求。

Vercel AI SDK

相比之下,Vercel AI SDK 的代码抽象做得更优雅,尤其在前端 UI 集成和部分 AI 功能封装上表现不错。但它的局限也很明显:- 绑定 Next.js:与 Next.js 框架深度耦合,对其他框架或语言的支持不足,限制了适用范围。

这些工具虽然各有亮点,但都无法提供一个统一的、灵活的解决方案。开发者仍然需要在不同项目中重复造轮子,浪费大量时间和精力。

二、MCP 的推出:恰逢其时,优势突出

Claude 推出 MCP 的时机可谓恰到好处,它抓住了开发者对标准化和开放性的迫切需求。以下是 MCP 受到欢迎的几个关键原因:

1. Claude 的品牌影响力

Claude Sonnet 3.5 作为一款性能卓越的语言模型,已在开发者群体中建立了良好口碑。这种信任为 MCP 的推广奠定了基础。开发者愿意尝试一个由 Anthropic(Claude 的开发公司)背书的协议,因为他们相信 Claude 团队能持续输出高质量的技术方案。

2. 开放标准的吸引力

MCP 是一个开放协议,不绑定任何特定模型或框架。这种开放性吸引了众多公司和社区的参与。相比之下,传统的 AI 集成方案往往受限于特定平台,而 MCP 提供了一个通用的桥梁,让服务商和开发者都能从中受益:

- 对服务商:可以基于 MCP 开放自己的 API 和功能,融入更大的生态。

- 对开发者:无需从头构建集成逻辑,直接利用现成的 MCP 服务即可增强 AI Agent 的能力。

3. 解决重复造轮子的问题

MCP 的标准化设计让开发者可以复用社区贡献的资源。例如,一个支持 GitHub 操作的 MCP 服务器一旦开发完成,其他开发者就能直接调用,而无需重复实现。这种"一次开发,多次使用"的模式极大提升了效率。

三、MCP 如何工作?——从架构到实例

要理解 MCP 为何受欢迎,我们需要看看它的工作原理。MCP 的设计并不复杂,但却非常实用。它通过一个清晰的架构,将 AI 模型与外部世界连接起来。

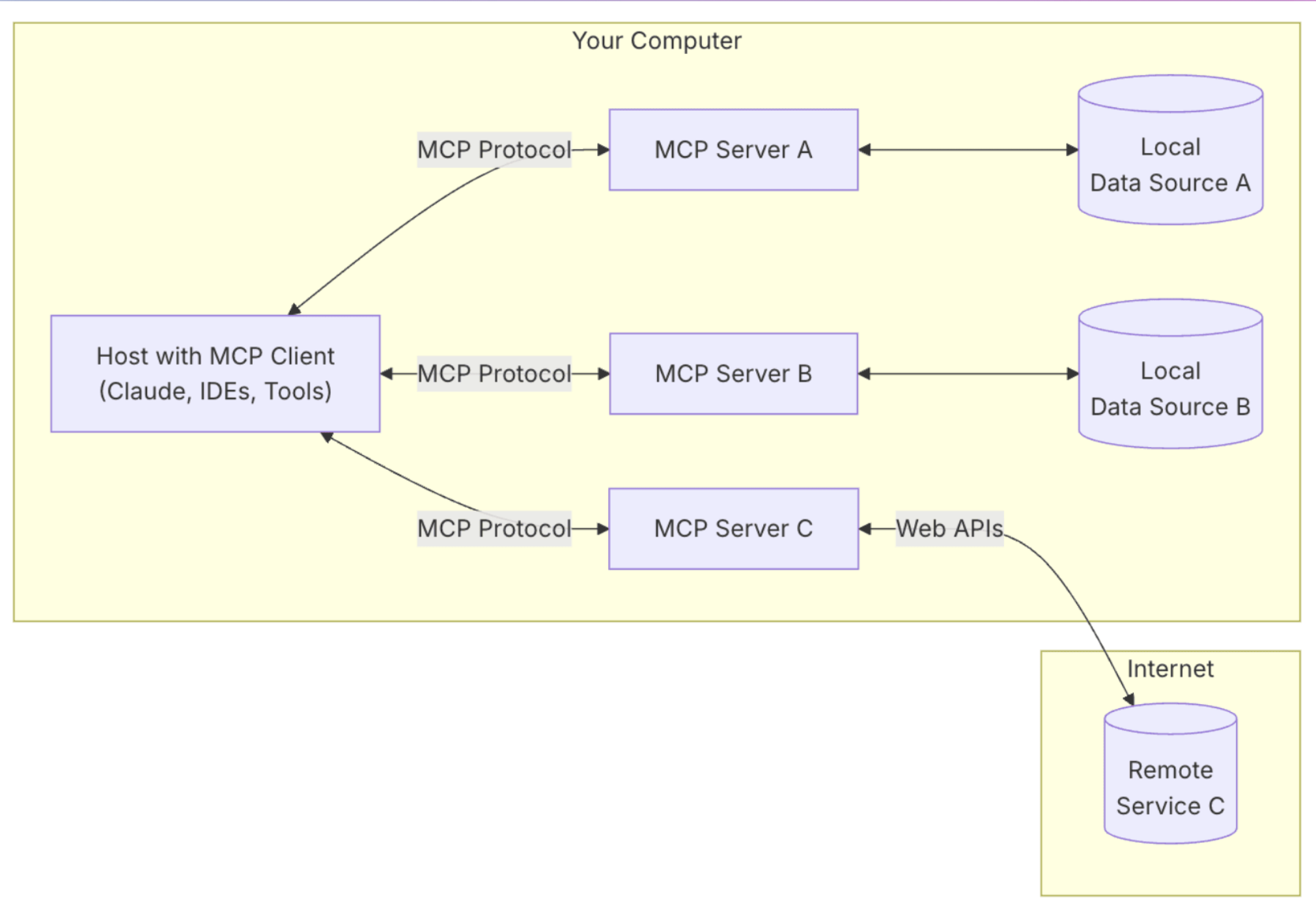

MCP 的核心架构

MCP 分为五个主要组件:

- MCP Hosts:运行 AI 模型的应用程序,例如 Claude Desktop 或 Cursor。

- MCP Clients:在 Hosts 内负责与服务器通信的模块。

- MCP Servers:核心部分,通过标准化协议为 Clients 提供工具、数据和上下文。

- Local Data Sources:本地文件、数据库等直接可访问的数据。

- Remote Services:外部 API 或服务,例如 GitHub 或 Slack。

其中,MCP Server 是整个协议的灵魂。它就像一个"中介",告诉 AI Agent 当前有哪些可用服务和数据,AI Agent 再通过函数调用(Function Calling)执行具体任务。

从 AI Chat 到 AI Agent 的进化

MCP 的价值还体现在它推动了 AI 的自动化进程:

- AI Chat:仅提供建议,用户需手动操作(例如复制粘贴)。

- AI Composer:能自动修改代码,但仍需人工确认,且功能有限。

- AI Agent:完全自动化,能独立完成复杂任务,例如读取 Figma 设计稿、生成代码、调试并提交到 GitHub。

MCP Server 的作用是为 AI Agent 提供支持,让它知道"能做什么"和"怎么做"。

一个简单的例子:GitHub MCP Server

假设我们要让 AI Agent 自动完成以下任务:搜索 GitHub 仓库、查找 Issues、判断是否为已知 Bug 并决定是否提交新 Issue。我们可以创建一个 GitHub MCP Server,提供以下能力:

- search_repositories:搜索仓库。

- search_issues:搜索 Issues。

- create_issue:创建新 Issue。

代码实现如下(简化版):

const server = new Server({ name: "github-mcp-server" });

server.setRequestHandler("listTools", async () => ({

tools: [

{ name: "search_repositories", description: "Search GitHub repositories" },

{ name: "search_issues", description: "Search issues in repositories" },

{ name: "create_issue", description: "Create a new issue" },

],

}));

server.setRequestHandler("callTool", async (request) => {

switch (request.params.name) {

case "search_repositories":

return await searchRepositories(request.params.arguments.query);

case "search_issues":

return await searchIssues(request.params.arguments);

case "create_issue":

return await createIssue(request.params.arguments);

}

});

async function searchRepositories(query) {

const url = `https://api.github.com/search/repositories?q=${query}`;

const response = await fetch(url);

return await response.json();

}这个服务器通过描述工具(description)和参数需求(inputSchema),让 AI Agent 明白如何与 GitHub 交互。最终,Agent 可以根据任务需求自主调用这些功能。

四、MCP 的生态价值:更强大的 AI Agent

MCP 的真正潜力在于它能支持更复杂的 AI Agent。以一个实际场景为例:用户输入"查询本地错误日志,将相关 Issues 发送到 Slack"。AI Agent 需要:

- 调用 Local Log Server 读取日志。

- 调用 GitHub Server 搜索相关 Issues。

- 调用 Slack Server 发送消息。

MCP 的标准化协议让这些服务器无缝协作,AI Agent 可以根据返回结果动态决定下一步操作。这种模块化设计不仅提升了灵活性,也降低了开发成本。

五、总结:MCP 为何赢得青睐?

Claude 推出 MCP 之所以被广泛接受,归根结底在于它抓住了开发者的核心需求:

- 解决了痛点:简化了 AI 与外部系统的集成过程。

- 开放生态:通过标准化吸引了社区和企业的参与。

- 实用性强:从简单工具到复杂 Agent,MCP 提供了清晰的实现路径。

对于开发者而言,MCP 不仅是一个技术协议,更是一个解放生产力的工具。未来,随着更多 MCP 服务器的开发和生态的完善,它有望成为 AI 集成领域的行业标准。如果你也对 AI 开发感兴趣,不妨试试 MCP,也许它会成为你下一个项目的秘密武器!